베이지안 확률에 대해

업데이트:

카테고리: 패턴 인식과 머신 러닝

책에서 베이지안 관점이란 것에 대한 설명이 되어있습니다. 이것을 이용하면, 확률을 이용해서 불확실성을 정량화하는 것이 가능하다고 합니다. 근데 이게 책의 설명을 읽어도 무슨 이야기인지 와닿지가 않네요.. 사실 글들이 조화롭게 연결되어 있지 않음을 가끔 느낍니다.. 그래서 최대한 이해한 바를 나름대로 적어보려고 합니다.

베이지안 확률에 대해

기본적으로 우리가 알던 확률이란 개념은 “반복 가능한 임의의 사건의 빈도수”의 시점에서 살펴보는 것입니다. 예를 들면, 주사위를 한번 던졌을 때, 1이 나올 확률은 6개의 경우의 수 중 1개이므로 1/6으로 표현하거나, 무한히 주사위를 던지게 되면 1/6이 나오는 것처럼 말이죠.

이제 좀 더 포괄적인 “베이지안 관점”에 대해 이야기를 해볼 것인데, 이것을 이용하면 확률을 이용해서 불확실성을 정량화하는 것이 가능하다고 합니다. 불확실성을 정량화하는 것이 가능이라는 말이 와닿는 느낌이 좀 없지만.. 그래서 이걸 좀 최대한 이해한 대로 예시를 통해 풀어보려고 합니다.

불확실성을 정령화?

2개의 주머니가 있다고 해보죠. 하나는 원형 주머니, 하나는 사각형 주머니입니다. 그리고 두 주머니를 눈 감고 선택할 확률은 각각 $p(원형)=2/3,\;p(사각형) = 1/3$ 이라고 합시다. 그리고 주머니 안에는 빨간색 공과 파란색 공이 섞여서 들어있습니다. 원형 주머니에서 빨간 공이 극단적으로 9개 있고, 파란공이 1개 있다고 합니다. 그리고 사각형 주머니에선 빨간공이 2개, 파란공이 8개 있다고 합시다!

이제 눈을 감고 주머니를 선택할 건데요. 상식적으로 확률에 의해서 자연스럽게 원형 주머니를 선택할 확률이 더 높기 때문에 주머니를 선택하면 원형이 뽑힐 확률이 높을 것입니다.

이번엔 눈을 감고 주머니 속의 공을 뽑았다고 해봅시다. 그리고 뽑은 공을 확인해 봤을 때, ‘공이 파란색이었다’는 것을 보았습니다! 그렇담 여전히 내가 선택한 주머니는 확률이 높은 원형 주머니일까요?? 이것은 굉장히 불확실한 예측을 하게끔 혼돈을 주게 됩니다. 분명 주머니의 확률 자체는 원형이 더 크므로 원형 주머니를 뽑았을 것 같습니다. 그러나 파란 공을 확인함으로써 저는 제 예측에 자신이 없습니다. 왜냐하면, 파란 공은 사각형 주머니에서 개수가 압도적으로 많기 때문이죠..

하지만 결국에는 직관적으로 나는 파란공을 보면서 “아, 사각형 주머니가 뽑혔겠는데?” 라고 생각하게 될 것 입니다. 왜냐구요? 이것 또한 파란공이 사각형 주머니에서 개수가 압도적으로 많기 때문입니다. 저는 이런 직관적인 생각 자체를 식으로 표현한 것이 바로 베이즈 이론이라고 생각합니다.

직관을 현실로!

자, 이제 베이즈 이론을 적용해서 직관이 현실이 됐는지 확인해 봅시다.

이전 글에서 베이즈 이론의 식을 얘기했습니다.

\[p(Y|X) = \frac{p(X|Y)p(Y)}{p(X)}\]예제에 확률 값을 줍시다.

- 원형주머니에서 빨간공이 선택될 확률 : $ p(빨간공|원형) = 9/10 $

- 파란공이 선택될 확률 : $p(파란공|원형) = 1/10$

- 사각형 주머니에서 빨간공이 선택될 확률 : $p(빨간공|사각형)= 2/10$

- 사각형 주머니에서 파란공은 선택될 확률 : $p(파란공|사각형)=8/10$

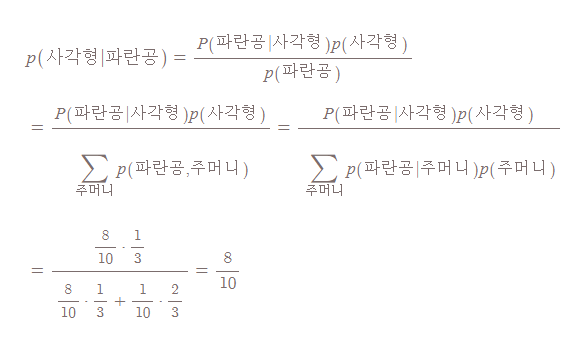

우리가 구하려고 하는 것은 파란공을 뽑았을 때, 사각형 주머니를 뽑을 확률인 $p(사각형|파란공)$ 입니다.

|

|---|

| 파란공을 뽑았을 때, 사각형 주머니를 뽑을 확률 |

| 이렇게 $p(사각형/ | 파란공)$은 8/10의 확률을 갖게 됩니다. 반대로 $p(원형/ | 파란공)$은 1-8/10 = 2/10 의 확률을 갖게 됩니다. |

어떻습니까, 생각했던 직관이 확률을 따라가는 것이! 따라서 어떤 결과를 예측할 때(주머니를 선택하는 것을 예측) 입력 데이터(공의 색깔을 선택)를 통해 불확실성을 정량화해서 예측을 할 수 있게 해주는 것을 책에선 이야기하고 싶은게 아닐까 싶네요!

위 식에서 우측 항의 분자의 conditional prob는 likelihood라고 부르고, 분자의 marginal prob는 prior prob라고 부릅니다. 그리고 좌측 항은 posterior prob라고 부릅니다. likelihood를 최대화하는 방향으로 파라미터를 결정하게 되는 것을 흔히 MLE라고 불리는 Maximum likelihood estimation 이라고 합니다. 이것은 흔히 빈도적 확률 관점에서 사용되는 estiamtion이라고 하네요.

베이지안 관점의 장점 중 하나는 prior prob를 inference 과정에 포함을 시킬 수 있다는 것입니다. 예를 들어, 동전을 3번 던졌는데 다 앞면이 나왔다는 데이터를 갖고, 모델을 학습하면 다음 동전 던지기 때도 앞면이 나올 확률이 1이라는 예측을 하게될 것입니다. 그러나 사실 뒷면이 나올 확률도 있죠. 그래서 여기에 베이즈 이론을 적용하게 된다면, $posterior\;\propto\;likelihood\; \ast \;prior$를 통해 prior prob를 적용함으로써 좀 더 합리적인 결과를 추론할 수 있게 됩니다.

그러나 단점도 존재하겠죠? 바로 prior distribution을 설정하는 것은 사용자이기 때문에 inference 과정에 사용자의 주관이 들어가게 된다는 것입니다.